Sztuczna inteligencja stała się głównym motorem napędowym innowacji w niemal każdej branży – wspiera rozwój medycyny, optymalizuje transport i logistykę, automatyzuje procesy biznesowe i zwiększa bezpieczeństwo usług bankowych i ubezpieczeniowych. Jej dynamiczny rozwój niesie ze sobą również liczne niebezpieczeństwa, które wymagają odpowiednich działań i regulacji. Dowiedz się, czym jest AI Act, jakie zasady wprowadza i jak może wpłynąć na rozwój firm nastawionych na cyfryzację.

Kluczowe wnioski z artykułu

- Nowe przepisy wprowadzone na terenie UE nakładają na firmy obowiązek dostosowania systemów AI do określonych standardów oraz określają wysokie kary finansowe za ich nieprzestrzeganie.

- Wdrożenie AI zgodnie z AI Act wymaga od przedsiębiorstw strategicznego podejścia i bliskiej współpracy zespołów prawnych, technologicznych oraz operacyjnych.

- Odpowiednie wdrożenie regulacji pozwoli firmom nie tylko na zgodność z prawem, ale także na budowanie zaufania klientów oraz silnej przewagi konkurencyjnej.

Zagrożenia i wyzwania AI – dlaczego sztuczna inteligencja potrzebuje regulacji?

Wraz z dynamicznym rozwojem sztucznej inteligencji stale rośnie liczba potencjalnych zagrożeń i niebezpieczeństw, które za sobą niesie – naruszenia prywatności, manipulacja informacjami czy algorytmy dyskryminujące określone grupy społeczne. AI rozwija się w tak dynamicznym tempie, że regulacje prawne nie są w stanie dotrzymać jej kroku. Brak jasnych zasad i norm etycznych prowadzi do sytuacji, w których AI może być wykorzystywana w sposób szkodliwy – stąd konieczność ciągłego dostosowywania przepisów. Właśnie dlatego Unia Europejska stworzyła AI Act – pierwsze kompleksowe przepisy regulujące sztuczną inteligencję na poziomie unijnym.

AI Act – gwarancja przejrzystości, bezpieczeństwa i innowacji

AI Act ma na celu zapewnienie bezpieczeństwa użytkowników oraz ochronę praw człowieka poprzez wprowadzenie jasnych regulacji dotyczących rozwoju i wdrażania AI. Główne cele AI Act to:

- Zapewnienie przejrzystości – użytkownicy AI muszą mieć jasność co do sposobu działania systemów oraz możliwości ich kontroli.

- Ochrona praw podstawowych – zakaz wykorzystywania AI w sposób naruszający prawa człowieka, np. w systemach manipulacji czy nielegalnym rozpoznawaniu twarzy.

- Promowanie innowacji – stworzenie ram umożliwiających rozwój odpowiedzialnych i bezpiecznych technologii opartych na sztucznej inteligencji.

Od kiedy obowiązują pierwsze regulacje?

Na początku lutego 2025 r. Komisja Europejska opublikowała wytyczne dotyczące zakazanych praktyk związanych ze sztuczną inteligencją określonych w rozporządzeniu (UE) 2024/1689 AI Act. Pełna wersja aktu jest dostępna w 24 językach, a dodatkowo istnieje możliwość skorzystania z narzędzi takich jak AI Act Explorer, Summary of the AI Act lub EU AI Act Compliance Checker, które pomagają w zrozumieniu przepisów.

Przepisy będą wchodzić w życie stopniowo od 2025 do 2027 roku, a ich nieprzestrzeganie może skutkować dotkliwymi karami finansowymi – nawet do 35 milionów euro lub 7% globalnego obrotu firmy. Dlatego tak ważne jest, aby zapoznać się z nowymi regulacjami, dokładnie je przeanalizować oraz przygotować się na ich wdrożenie.

Nieprzestrzeganie nowych przepisów może skutkować dotkliwymi karami finansowymi nawet do 35 milionów € lub 7% globalnego obrotu firmy.

Od 2 lutego 2025 r. obowiązują rozdziały I i II (art. 1-5), które wprowadzają kluczowe wymogi dotyczące AI. Rozdział I art. 3 wprowadza, między innymi, definicję AI, natomiast artykuł 4 z tego samego rozdziału określa kompetencje w zakresie AI. Rozdział II art. 5 opisuje, jakie praktyki stwarzają nieakceptowalne ryzyko naruszenia praw podstawowych, czyli w skrócie praktyki zakazane.

Ponadto każde państwo członkowskie UE jest odpowiedzialne za wdrożenie ustawy o sztucznej inteligencji do swoich krajowych ram prawnych. Aby zapewnić zgodność i egzekwowanie przepisów, kraje muszą ustanowić organ nadzorczy odpowiedzialny za monitorowanie działań związanych ze sztuczną inteligencją, ocenę zgodności i nakładanie sankcji w razie potrzeby. Organy krajowe będą współpracować z Komisją Europejską i innymi organami regulacyjnymi w celu utrzymania spójnego podejścia w całej UE.

Regulacje i nadzór AI w Polsce

W lutym 2025 roku Ministerstwo Cyfryzacji zaprezentowało drugą wersję projektu Ustawy o systemach sztucznej inteligencji. Głównym celem projektu jest wdrożenie do polskiego prawa przepisów unijnego AI Act. Najnowsza wersja projektu uwzględnia szereg uwag z pierwszej tury konsultacji społecznych i jest aktualnie w fazie uzgodnień międzyresortowych, opiniowania i konsultacji publicznych [informacja z dnia 7 kwietnia 2025 roku].

Zgodnie z projektem ustawy organem nadzoru rynku w zakresie systemów sztucznej inteligencji na terenie Rzeczypospolitej jest KRIBSI – Komisja Rozwoju i Bezpieczeństwa Sztucznej Inteligencji. Pełni ona funkcję centralnego punktu kontaktowego i współpracuje zarówno z organami krajowymi, jak i unijnymi. KRIBSI (zwana w samym AI Act Komisją AI), w swoich założeniach będzie nadzorować również tzw. piaskownice regulacyjne (instytucje pozwalające na bezpieczne testowanie systemów AI), realizować obowiązki informacyjne oraz podejmować działania monitorujące, komunikacyjne i edukacyjne wspierające rozwój sektora AI w Polsce.

Zgodnie z projektem ustawy w skład komisji wchodzą przedstawiciele m.in.:

- prezesa Urzędu Ochrony Konkurencji i Konsumentów,

- Komisji Nadzoru Finansowego,

- rzecznika Praw Dziecka,

- Krajowej Rady Radiofonii i Telewizji,

- prezesa Urzędu Komunikacji Elektronicznej,

- Państwowej Inspekcji Pracy,

- prezesa Urzędu Rejestracji Produktów Leczniczych, Wyrobów Medycznych i Produktów Biobójczych.

Do Komisji AI można zwrócić się z prośbą o opinię indywidualną lub generalną w zakresie sztucznej inteligencji. Koszt złożenia wniosku o interpretację stanowi niewielki wydatek w porównaniu z kosztami budowy modeli AI i zapewnienia pełnej zgodności regulacyjnej.

Projekt ustawy przewiduje również możliwość zmniejszenia wysokości kar pieniężnych, jeżeli ukarany podmiot w ciągu 3 miesięcy od otrzymania decyzji wdroży rekomendacje zawarte w ostrzeżeniu, a naruszenie nie doprowadzi do śmierci lub poważnego uszczerbku na zdrowiu. W przypadku „nadzwyczajnych okoliczności łagodzących” istnieje nawet możliwość odstąpienia od nałożenia sankcji.

Ponieważ projektowana ustawa w istotny sposób zmieni funkcjonowanie rynku IT w Polsce, warto monitorować jej postępy, by ocenić możliwe konsekwencje biznesowe tych regulacji.

Aktualna definicja AI – klucz do zrozumienia przepisów

Aby skutecznie dostosować się do przepisów AI Act, kluczowe jest pełne zrozumienie, czym według tego aktu prawnego jest sztuczna inteligencja. W rozdziale I, artykule 3 AI Act określa AI jako oprogramowanie zaprojektowane do działania z różnym poziomem autonomii, generujące wyniki wpływające na środowiska fizyczne lub wirtualne na podstawie metod uczenia maszynowego, podejść logicznych lub statystycznych. Tak szeroka definicja pozwala na objęcie regulacjami zarówno prostych systemów automatyzacji, jak i zaawansowanych algorytmów uczenia maszynowego.

System AI oznacza system maszynowy, który został zaprojektowany do działania z różnym poziomem autonomii po jego wdrożeniu oraz który może wykazywać zdolność adaptacji po jego wdrożeniu, a także który – na potrzeby wyraźnych lub dorozumianych celów – wnioskuje, jak generować na podstawie otrzymanych danych wejściowych wyniki, takie jak predykcje, treści, zalecenia lub decyzje, które mogą wpływać na środowisko fizyczne lub wirtualne.

AI Act, roz. I, art. 3, pkt 1

Poziomy ryzyka związanego z AI – co jest dozwolone, a co nie?

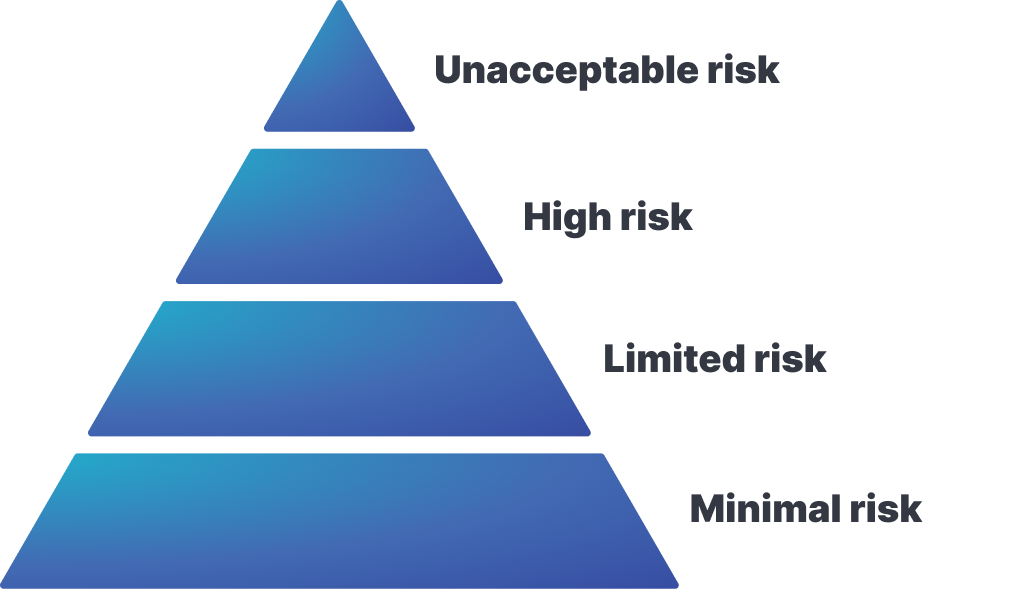

AI Act określa różne poziomy ryzyka AI.

- Niedopuszczalne praktyki (np. manipulacja, systemy nadmiernej inwigilacji) – są całkowicie zakazane (Rozdział II, Art. 5).

- Wysokie ryzyko (np. AI w rekrutacji, ocenie kredytowej) – systemy o tym poziomie ryzyka wymagają dopełnienia obowiązków w zakresie dokumentacji, kontroli i bezpieczeństwa (Rozdział III art. 6, 8-17).

- Ograniczone ryzyko (np. chatboty, generatory treści) – takie systemy powinny spełniać wymogi przejrzystości (użytkownicy powinni być informowani, że rozmawiają z botem, a treść jest generowana). Rozdział IV opisuje, jakie są obowiązki dostawców i podmiotów wdrażających systemy AI w zakresie przejrzystości.

- Niskie lub minimalne ryzyko – systemy o niskim poziomie nie wymagają szczególnych obostrzeń.

Wnioski

Organizacje, których priorytetem jest przeprowadzenie skutecznej transformacji cyfrowej, powinny na bieżąco śledzić zmieniające się przepisy dotyczące sztucznej inteligencji – uczyć się i dostosowywać swoje systemy AI, tak aby działały w sposób zgodny z obowiązującymi regulacjami. Bezpieczną ścieżką w procesie wdrażania etycznych rozwiązań AI jest wybór doświadczonego i wiarygodnego partnera technologicznego, który zapewni Twojej firmie najlepsze praktyki w zakresie przejrzystości, bezpieczeństwa i zgodności z przepisami oraz wdroży optymalne rozwiązania napędzające wzrost i zysk przedsiębiorstwa.